Pour optimiser les résultats des campagnes emails, le sujet de l’A/B testing est proposé systématiquement. Presque tous les outils proposent une fonctionnalité d’A/B test, alors pourquoi s’en priver ? En plus, une fois que l’on a compris comment l’utiliser, c’est presque un peu une drogue (et puis c’est rigolo). Par contre, une question revient toujours « Marion, pour un test d’objet, on prend bien le taux d’ouverture, on est d’accord ? » Comme c’est une question récurrente de la part de nos clients, ça méritait un chti’ article à ce sujet !

Petit retour sur ce qu’est l’A/B testing

Définition : L’A/B testing permet de tester 2 variantes d’un email envoyé chacun aléatoirement sur une portion de la cible. Ensuite, la version qui a le mieux performé sera envoyée au reste de la cible.

D’abord, décortiquons les termes de ces deux phrases et plaçons-y nos recos…

- « plusieurs variantes »: en fait, on peut TOUT tester (et on DOIT tout tester) : objet, préheader, expéditeur, positionnement d’un bouton, libellé d’un call to action, couleur d’un bouton, image, , design, fonctionnalités ou bénéfices à mettre en avant, façon d’annoncer un prix, emplacement des éléments, moment d’envoi… Attention, cependant, à ne tester qu’UNE SEULE variable à la fois. Si vous faites un test d’objet, ne changer QUE l’objet et pas le préheader ou la créa. On ne saurait pas quelle est la variante qui a véritablement eu une influence !

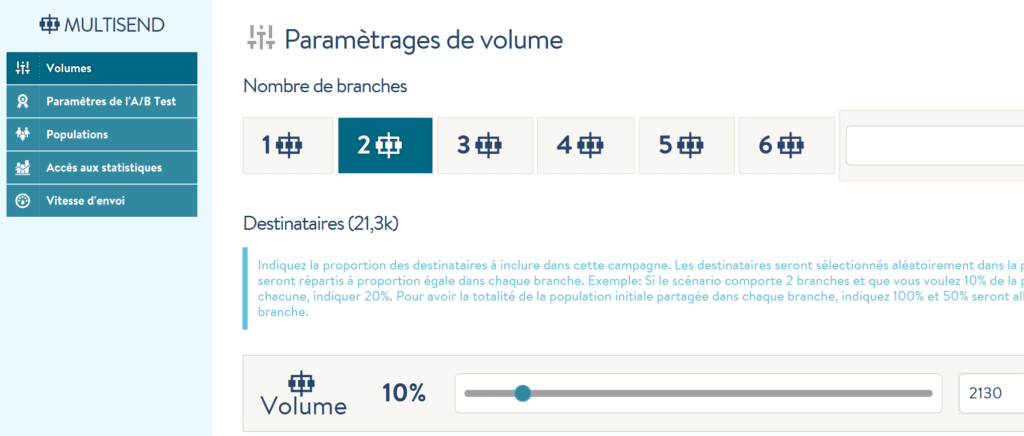

- « sur une portion de la cible »: on prend généralement 10% de la base de contacts. En tout cas, on s’assure qu’on a au moins 1000 contacts dans chaque segment. 1000 étant un nombre assez représentatif.

- « Ensuite »: on aime bien laisser 24h, ou en tout cas au moins 12h ouvrable (comprendre ici : si j’envoie un test A/B à 8h, alors la version gagnante partira dans l’idéal le lendemain à 8H ou alors si on est pressé, le soir à 20h)

- « le mieux performé » : voilà ce qui entraîne bien souvent un petit débat !

Quel indicateur de performance : ouverture ou clic ?

Dans le cas d’un test d’objet, beaucoup de personnes ont tendance à prendre le taux d’ouverture comme indicateur de performance d’une campagne d’A/B test. En se disant, si ça ouvre plus, ça clique plus donc j’aurai plus de conversions. Ce qui est logique au premier abord. Sauf qu’en regardant de plus près les résultats des campagnes de tests, on constate souvent que le nombre de clics de la version A peut être supérieur à la version B alors même que le nombre d’ouvertures de la version A est inférieur à la version B.

L’objectif d’une campagne email est d’obtenir le plus de clics possibles (hors clic sur lien de désabonnement bien sûr ! ). Dans cette logique-là, on va plutôt prendre le nombre de clics comme indicateur de sélection de la version gagnante !

Besoin d’aide ?

Lire du contenu ne fait pas tout. Le mieux, c’est d’en parler avec nous.

Mieux encore, si vous avez le nombre de conversions remonté dans votre outil de gestion de campagnes emailing, vous pourriez choisir cet indicateur comme indicateur de sélection.

Par contre, on est d’accord, votre nom d’expéditeur de newsletter doit être le plus stable et permanent possible. Ce n’est donc pas un élément de créativité. Quoi qu’il arrive, c’est sur l’objet que vous allez devoir jouer pour améliorer vos performances d’ouverture.

L’A/B test, facile à mettre en place ?

OUI car on retrouve un module d’A/B test dans pratiquement tous les outils de gestion de campagnes marketing.

Par contre, voici une petite liste de ce qui peut faire la différence d’un outil à l’autre (pensez donc à bien vérifier ces points lors des démonstrations dans le cadre d’un appel d’offre dans le choix d’un nouvel outil de gestion de campagnes eCRM. Ah oui, on peut vous accompagnez là-dessus ;-))

- Manuel ou programmé: certains outils (mais ils sont très peu rassurez-vous) proposent un module d’A/B test mais manuel… c’est-à-dire que vous devez regarder vous-même 24h après les performances de vos 2 campagnes de tests et choisir la campagne qui selon vous a mieux performée. Bref, le risque d’oubli et d’erreur sont très grands !

- Les indicateurs de sélection: on retrouve TRES souvent le taux d’ouverture et le taux de clic comme indicateur mais moins souvent le taux de conversion, de désabonnement, de nombre de répondants à une enquête… qui peuvent aussi être très utiles lors de campagnes à objectif spécifique

- Le nombre de versions testables : certains outils limitent le nombre de versions à tester, chez d’autres c’est illimité.

- L’A/B TEST dans un scénario : Très peu d’outils malheureusement offrent la possibilité de faire de l’A/B test dans des scénarios…Pourtant, ça serait un véritable avantage concurrentiel.

- Le design/l’ergonomie : ça c’est comme tout, l’ergonomie est plus ou moins user-friendly selon les outils.

Intégrer les A/B test dans votre planning d’envoi

Comme on le disait plus haut, on DOIT tester TOUS les éléments d’un email. Et ils sont nombreux. Le mieux et le plus structurant est d’inclure ces tests à votre planning d’envoi.

De cette manière, vous allez historiser les éléments tester et leurs résultats pour ancrer votre connaissance des recettes à succès. Vous pourrez déterminer quels contenus et compositions visuelles sont les plus adaptés à vos cibles. Cela facilitera votre prise de décision et vous permettra de créer des campagnes d’emailing de plus en plus efficaces pour votre cible. Et là-dessus aussi, on peut vous aider, on adooore vous coacher !

Laisser un commentaire